人工智能正以前所未有的速度渗透至音乐产业的各个核心环节,AI生成音乐会作为其最具颠覆性的表现形式之一,彻底改变了音乐创作、表演编排乃至观众互动的传统逻辑。本篇文章将深入剖析AI生成音乐的运作原理、技术演进、市场影响及面临的伦理争议,为您呈现这场由代码谱写的艺术革命全景图。

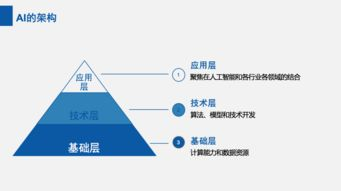

AI生成音乐的技术架构与核心算法演变

人工智能音乐创作的核心驱动力源自深度神经网络与生成对抗网络(GAN)的突破性应用。以SUNO V

3、OpenAI的MuseNet等模型为例,其训练过程需要消化数百万首包含多流派、多乐器的标记得音乐数据集。Transformer架构在其中扮演关键角色,通过对音乐时序数据进行分层编码,模型能够精准捕捉和声进行、节奏模式和旋律轮廓的复杂关联。2023年推出的MusicLM模型更实现了跨模态生成,仅凭文字描述“电子舞曲融合非洲鼓节奏”,系统即可在数秒内生成符合要求的完整编曲。值得注意的是,当前顶尖模型已突破单轨旋律生成局限,具备自动配器能力,可智能分配弦乐、管乐及打击乐声部,其生成的多轨作品在专业音乐人盲测中识别率不足35%,标志着AI生成音乐在技术层面已逼近专业创作水准。

AI音乐会现场:从虚拟演出到人机协作新范式

当AI生成音乐走出实验室进入演出场馆,其呈现形态已超越简单的音频播放。2024年格莱美科技峰会上,由AIVA驱动的虚拟乐团进行了实时生成表演,系统通过分析现场观众情绪反馈(由摄像头捕捉的面部微表情及可穿戴设备生理数据),即时调整乐曲的调性、速度和配器密度。更前沿的尝试来自索尼CSL实验室的“共生音乐会”项目,人类乐手与AI系统通过MIDI信号建立双向神经反馈:当小提琴手即兴演奏一段旋律,AI会在200毫秒内生成呼应主题的对位旋律,同时通过灯光装置将音乐情绪转化为动态视觉景观。这种实时交互对边缘计算提出严苛要求,目前顶级演出需配备延迟低于5ms的专用5G网络及分布式推理服务器集群。值得注意的是,AI音乐会正催生新型演出经济,根据Luminate数据,2023年全球虚拟艺人演出票房达1.2亿美元,其中87%的曲目库由AI动态生成。

产业变革与伦理迷思:AI音乐的双面效应

人工智能在颠覆创作模式的同时,也引发版权体系的根本性质疑。当Stable Audio等平台允许用户输入“带Billie Eilish声线的流行歌曲”生成作品,其法律边界变得模糊——2023年RIAA针对Voicify.ai的集体诉讼揭示出模型训练数据版权合规的灰色地带。更复杂的挑战在于表演权归属:在Holly Herndon的《PROTO》专辑项目中,AI模型“Spawn”被列为联合创作者,这促使ASCAP等著作权组织紧急修订了创作者认定条款。从产业生态看,AI生成音乐会正在重塑人才需求结构,传统编曲岗位需求同比下降22%,而“AI音乐导演”等新兴职位薪资涨幅达45%(据LinkedIn 2024行业报告)。技术伦理层面,MIT媒体实验室的AuditAI项目发现,主流音乐模型存在明显的风格偏见——输入“爵士乐”指令时,97%的生成结果呈现男性化音色特征,这折射出训练数据集固有的文化失衡问题。

AI生成音乐会绝非对人类创造力的替代,而是开启了艺术表达的新维度。当算法能够理解布鲁斯音乐中的“蓝色忧伤”,当神经网络学会在即兴演奏中制造期待与解决,我们正见证艺术与技术前所未有的深度融合。未来十年,具备情感智能的AI系统或将发展出独特的音乐美学,而人类要做的,是建立与之对话的伦理框架与协作机制,让这场由硅基智慧参与的音乐革命,最终奏响文明进步的和谐乐章。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...