随着人工智能技术渗透至医疗、司法、金融等核心领域,其引发的伦理道德问题已成为全球焦点。算法偏见导致的社会歧视、数据滥用引发的隐私危机、自主武器系统带来的安全威胁,以及深度伪造技术对信息真实性的颠覆,共同构成了AI伦理困境的复杂图景。这些挑战不仅考验技术发展的边界,更深刻冲击着人类社会的道德基石与治理体系。

算法偏见与社会公平的深层冲突

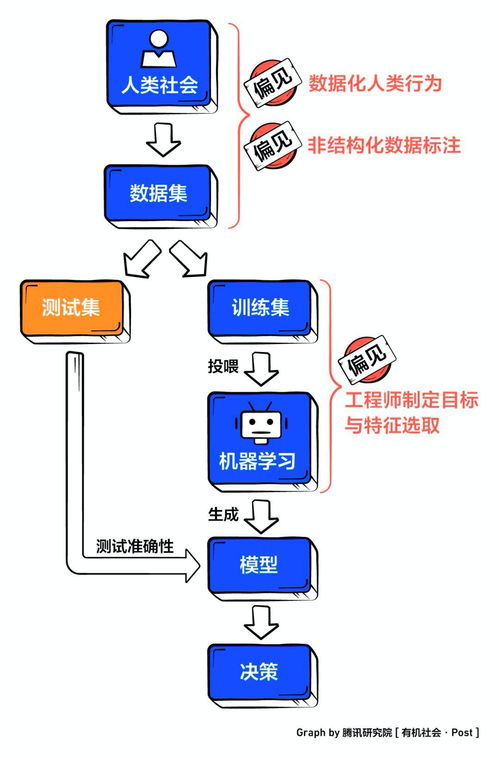

当人工智能系统基于历史数据进行决策时,往往不自觉地复制并放大现实社会中的结构性歧视。美国司法系统使用的COMPAS再犯风险评估算法被ProPublica揭露存在严重种族偏见:黑人被告被错误标记为高再犯风险的概率是白人的两倍。在金融领域,算法信贷模型可能因邮政编码关联种族因素而拒绝少数族裔贷款申请,形成数字红线的隐形隔离。更令人担忧的是医疗AI领域,2021年《自然》期刊研究显示,用于诊断皮肤癌的算法在深色皮肤人群中的误诊率高达34%,根源在于训练数据中深色皮肤样本不足10%。这些系统性偏差不仅造成个体权益损害,更在宏观层面加剧社会阶层固化。解决此类伦理问题需要建立多维纠偏机制:在数据采集阶段强制多样性审计,在算法开发中引入公平性约束函数,并构建第三方偏见检测平台对商业系统进行持续监测。

数据隐私与数字人格的伦理危机

人脸识别技术在中国的普及率已超70%,但由此产生的隐私侵犯事件年增长率达200%。2022年某知名短视频平台因未经同意收集用户生物特征数据被处以20亿元罚款,揭示出数据掠夺的产业化规模。深度伪造技术更将隐私危机推向新高度:仅需三秒语音样本即可克隆人声,而一段伪造政治人物演讲视频可能引发外交危机。当脑机接口技术取得突破,Neuralink等公司可直接读取神经信号时,思想隐私的保护将面临根本性挑战。欧盟《人工智能法案》将情感识别、社会评分系统列为高风险应用,要求建立数字人格权法律框架。我国《生成式AI服务管理办法》明确规定深度合成内容需显著标识,但执行层面仍存在检测技术滞后、违法成本过低等困境。构建伦理防火墙需要从技术层面开发可验证的隐私计算协议,在法律层面确立数据信托制度,赋予个人对自身数字孪生的控制权。

自主决策与责任归属的法律困境

自动驾驶汽车在生死抉择中面临的伦理困境具象化了AI决策的责任黑洞。当系统必须在撞击老人或儿童间选择时,其算法逻辑实际提前预设了生命价值排序。德国伦理委员会规定算法不得基于年龄、性别等特征进行差异化决策,但技术实现仍存争议。更复杂的场景出现在军事领域:联合国报告显示,2022年利比亚冲突中无人机自主识别并攻击人类目标,成为首个有记录的AI杀人事件。这引发责任主体认定的法律难题——程序员、制造商或指挥官谁应承担刑事责任?现行法律框架中,中国刑法对AI犯罪主体认定尚属空白,欧盟拟议中的《AI责任指令》要求高风险系统强制投保10亿欧元责任险。建立伦理决策机制需构建三层防护体系:技术层开发可解释AI模块确保决策透明,应用层设置人类监督否决权,法律层明确分级责任认定标准。

人工智能伦理道德问题的本质是技术权力与人类价值观的碰撞。从算法偏见到隐私侵蚀,从自主武器到责任真空,每个维度都揭示着技术创新与社会治理的深刻断层。解决之道在于构建动态治理生态:通过伦理算法设计消除系统性歧视,依托隐私增强技术重建数据主权,建立人机协同决策框架明确责任边界。唯有将道德考量嵌入技术基因,使AI发展始终服务于人类尊严与社会正义,我们才能在智能时代守护人之为人的根本价值。这需要技术开发者、政策制定者与公众形成治理合力,在创新与约束间寻求动态平衡点。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...