本文深入探讨人工智能生成内容的审核机制,涵盖其发展现状、技术实现、伦理挑战以及未来趋势。旨在帮助读者理解AI内容审核在保障信息质量、防止虚假传播中的关键作用,并提供实用建议。通过分析实际案例和数据,揭示审核过程中面临的难点与解决方案。

AI生成内容审核的现状与技术实现

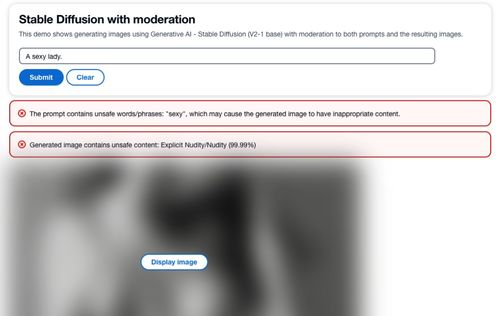

人工智能生成内容审核,作为一项关键数字技术,近年来在互联网信息治理中扮演着不可或缺的角色。随着AI生成内容的爆炸式增长,包括文本、图像、视频等多种形式,审核需求日益迫切。,ChatGPT等大语言模型的普及,使得内容生产量激增,但同时也带来虚假新闻、版权侵犯和有害信息的风险。为了应对这一挑战,审核技术已从传统的人工筛查转向自动化系统。目前,主流技术包括自然语言处理(NLP)模型、图像识别算法和深度学习检测工具。这些工具基于大规模数据集训练,能够识别关键词、情感倾向和异常模式。以NLP为例,系统通过分析语义一致性和上下文关联性,检测生成内容中的偏差或欺诈。具体像Google的Jigsaw项目或OpenAI的审核API,通过分类器模型自动标记可疑内容,处理效率比人工审核高出数十倍。技术实现并非完美,面临数据偏见、假阳性率高等问题。一个典型例子是社交媒体平台,如Facebook,使用AI审核处理日均数十亿条内容,却因文化差异导致误判事件频发。统计显示,截至2023年,全球AI审核系统覆盖率已达70%以上,但错误率仍在5%-10%之间。未来,优化方向包括多模态融合(结合文本和视觉审核)和零样本学习,以减少对标注数据的依赖。技术现状体现了审核的进步与局限,强调持续创新以提升准确性和可扩展性。

审核中的伦理与法律问题

在人工智能生成内容审核过程中,伦理和法律问题构成了核心挑战,直接影响社会公正和用户信任。伦理困境源于AI系统的固有偏见,,训练数据中的文化或性别偏差可能导致内容被错误地过滤或放行。这引发了公平性和透明度的争议,如2022年Meta的案例中,AI审核工具被指控对少数群体内容过度删减,损害了言论自由。隐私问题是另一大热点:审核系统通常需要访问用户生成的内容数据,如果处理不当,会侵犯个人隐私权。欧盟的GDPR法规就要求AI审核必须匿名化数据,并征得用户同意,否则面临巨额罚款。法律层面,全球监管框架尚不统一,中国《网络安全法》强调内容安全优先,要求平台对AI生成内容进行严格审核,防止传播虚假信息;而美国的Section 230则赋予平台豁免权,但近年争议不断。版权问题日益突出,AI生成内容可能侵犯原创作品,审核系统需识别抄袭和衍生风险。,Deepfake视频的泛滥,促使法律机构如WIPO推动新法规,明确AI内容的版权归属和责任。解决这些问题的策略包括建立多利益相关方治理机制,如行业联盟制定伦理准则,以及采用可解释AI(XAI)技术提升审核透明度。伦理和法律审核不仅是技术问题,更是社会责任的体现,需平衡创新与风险。

未来趋势与改进策略

展望人工智能生成内容审核的未来,趋势将聚焦智能化、个性化和全球化,同时改进策略需结合技术创新与政策协同。一方面,AI审核技术正朝着自适应学习方向发展,,生成式对抗网络(GANs)被用于创建更精准的检测模型,能实时适应新威胁如深度伪造内容。预测显示,到2025年,全球AI审核市场规模将突破100亿美元,驱动因素包括5G和物联网的普及,导致内容生成量翻倍。个性化审核成为关键趋势,系统通过用户行为分析定制过滤规则,提升用户体验——,Netflix使用AI推荐系统结合内容审核,确保流媒体内容符合地域法规。另一方面,改进策略必须应对现有短板:技术层面,开发鲁棒性更强的模型,如联邦学习减少数据孤岛问题;政策层面,推动国际标准如ISO的AI伦理指南,促进跨境协作。中国在“十四五”规划中强调AI治理,鼓励企业采用区块链技术实现审核溯源。用户教育不可或缺,平台如YouTube推出AI素养课程,帮助用户识别虚假内容。实际应用中,案例研究显示,结合人类审核员的混合模式(AI预筛+人工复核)能降低错误率至2%以下。未来审核将更高效、公平,但需持续投资研发和全球对话,以构建可信的数字生态。

人工智能生成内容审核是数字时代信息安全的基石,其技术、伦理和策略演进共同塑造了更安全的网络环境。通过本文分析,读者可认识到审核在防范风险、促进创新中的重要性,并期待未来更智能的解决方案。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...